Archivo robots.txt: ¿Qué es?

Te contamos todo lo que necesitas saber sobre robots.txt en este artículo

En breve

Robots.txt es un archivo que indica a los motores de búsqueda a qué páginas de un sitio web pueden acceder y a cuáles no. Te ayuda a controlar la forma en que los motores de búsqueda rastrean e indexan tu sitio web.

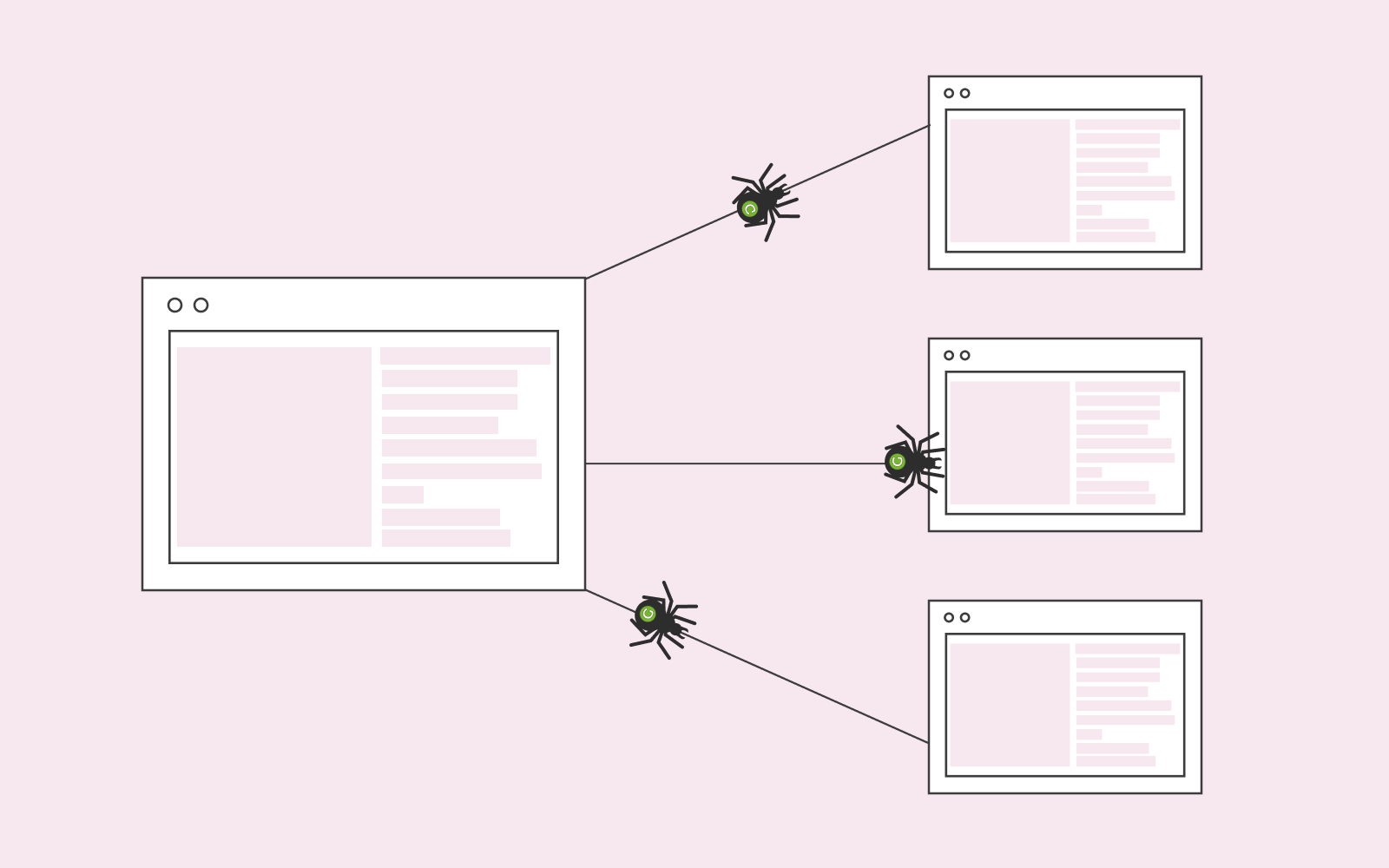

Lo primero que deberías saber es que el archivo robots.txt vive en tu sitio web. Otro dato importante es que las arañas inteligentes de los motores de búsqueda buscarán automáticamente tu robots.txt para recibir instrucciones antes de rastrear tu sitio web. Por lo tanto, el mejor lugar para guardar tu archivo robots.txt es tu directorio raíz, ya que es el primer lugar al que las arañas acudirán para pedir instrucciones.

Puedes comprobar si tienes el archivo robots.txt en tu sitio web haciendo una búsqueda en www.elnombredetuweb.com/robots.txt

Google recomienda a todos los titulares de un sitio web que tengan el archivo robots.txt. Si los rastreadores de Google no pueden encontrar tu archivo robots.txt, lo más probable es que el motor de búsqueda no rastree todas las páginas importantes de tu sitio web. El trabajo de un motor de búsqueda es rastrear e indexar tu sitio web para que a las personas lo puedan encontrar.

¿Para qué sirve el archivo robots.txt?

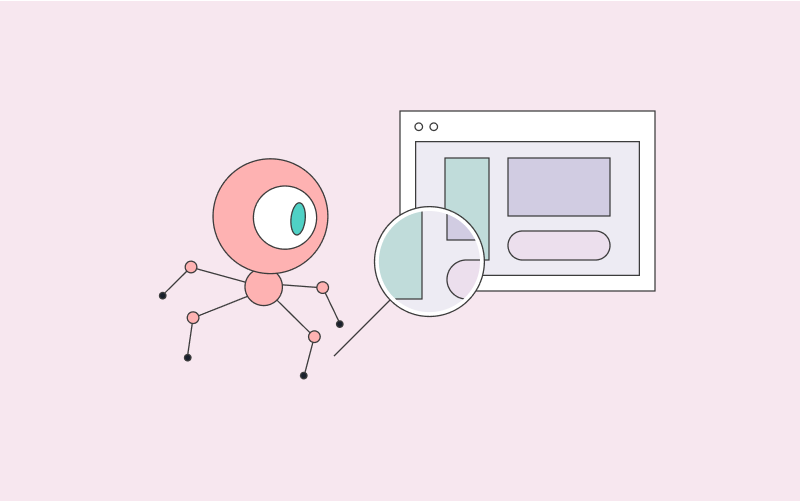

Robots.txt te permite bloquear partes de tu sitio web e indexar otras. Puedes elegir entre “Permitir” o “No permitir” determinadas páginas y carpetas de tu sitio web.

Si permites ciertas páginas, estás posibilitando que las arañas vayan a esa zona específica de tu sitio web y la indexen. Por el contrario, si eliges “no permitir” ciertas páginas, significa que no quieres que las arañas encuentren esas páginas y/o áreas de tu sitio web.

robots.txt permite que tu sitio web esté disponible y sea accesible en los motores de búsqueda. Así que, por ejemplo, si tienes una página de contacto en tu sitio web, puedes decidir bloquearla con la ayuda de robots.txt. De esta manera, Google rastreará otras páginas importantes de tu sitio web y no perderá tiempo en rastrear una página a la que realmente no te importa que la gente tenga acceso desde el motor de búsqueda.

Al hacer esto, le estás diciendo a Google que no rastree el contenido de tu página de contacto. Por supuesto, también puedes bloquear tu sitio web por completo con robots.txt si así lo deseas.

¿Cómo funciona robots.txt?

Existen varios tipos de rastreadores para diferentes motores de búsqueda y plataformas. Solemos llamar a estos rastreadores “agentes de usuario”. Así que cuando decides permitir o no un área concreta de tu sitio web, puedes elegir un rastreador específico, como por ejemplo, Googlebot (los rastreadores de Google) como agente de usuario, o puedes utilizar un * para elegir a todos los rastreadores que existen en Internet.

Puedes hacer muchas cosas avanzadas con robots.txt, como bloquear URLs, directorios o incluso parámetros de URL específicos.

El mismo método se aplica a las páginas que quieres que Google rastree y preste más atención. Puedes indexar estas páginas favoritas con la ayuda de robots.txt.

Tiempo de espera

Puedes establecer tiempos de espera en tu archivo robots.txt. Por ejemplo, si no quieres que una araña rastree tu sitio web tan rápidamente, puedes especificar un tiempo de espera. Es decir, le estás diciendo a las arañas el tiempo que deben esperar para rastrear tu sitio web.

Deberías utilizar el tiempo de espera para asegurarte de que las arañas no sobrecarguen tu servidor web.

Eso sí, recuerda que Google no admite retrasos. Si no quieres sobrecargar tu servidor web con los robots de Google, puedes poner un límite a la tasa de rastreo. Puedes elegir tu tasa de rastreo preferida en Google Search Console para ralentizar a las arañas.

Coincidencia de patrones

Si tienes un sitio web más extenso, puedes considerar implementar la coincidencia de patrones. Tanto si se trata de Google como de cualquier otro motor de búsqueda, puedes indicarles a las arañas que revisen y rastreen tus páginas en función de un conjunto de reglas.

La coincidencia de patrones es un conjunto de reglas que quieres que los rastreadores cumplan. Por ejemplo, puedes bloquear las URLs que tengan la palabra “sitio web”.

¿Por qué deberías utilizar robots.txt?

Muchas personas utilizan robots.txt para impedir que otras personas rastreen sus sitios web, ya que no solo los motores de búsqueda rastrean tu sitio web; hay otras personas que también intentan acceder a tu web constantemente. Este rastreo continuo llevado a cabo desde varios frentes, ralentiza no solo tu web, sino tu servidor también, que resulta en una experiencia negativa para el usuario. Además, estos widgets de terceros pueden causar problemas en el servidor que tendrás que resolver.

También puedes utilizar robots.txt para impedir que otros copien contenido de tu sitio web o analicen los cambios que realizas. robots.txt es una manera excelente de bloquear cosas que no quieres en tu sitio web.

No obstante, ten en cuenta que si un tercero está muy interesado en tu sitio web, hay programas, como Screaming Frog, que le permiten ignorar el “bloqueo” y rastrear tu sitio web. Por lo tanto, no deberías confiar al cien por cien en robots.txt cuando se trate de proteger ciertos aspectos de tu sitio web.

Probador de robots.txt o robots.txt checker

Puedes utilizar Google Search Console para ver si estás bloqueando alguna página con el probador de robots.txt. Te recomendamos comprobarlo de vez en cuando para asegurarte de que no has bloqueado ninguna página importante por equivocación.

Ten mucho cuidado cuando trabajes con robots.txt., ya que puedes causar graves daños a tu sitio web si impides, sin querer, que todo tu sitio web pueda ser indexado.