Vad är robots.txt?

I korthet

Robots.txt är en fil som berättar för sökmotorer vilka sidor de har åtkomst till eller inte på en webbplats. Den ger även webbplatsägare kontroll över hur deras webbplats söks igenom och indexeras av sökmotorer.

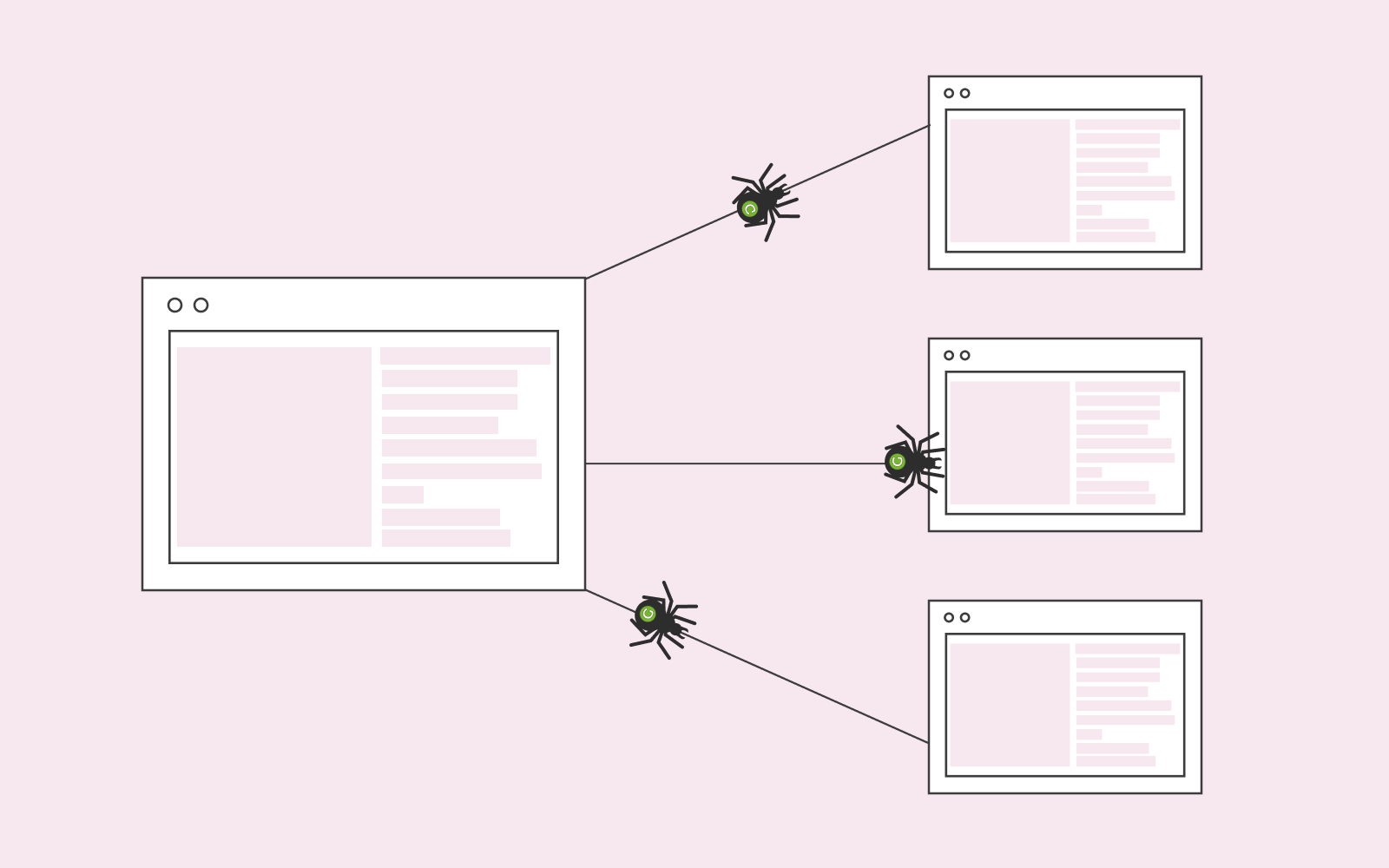

Robots.txt är en fil som finns på din hemsida. Alla sökmotorer kommer leta efter den robots.txt-fil som finns på hemsidan för att ta emot instruktioner från den innan sökmotorernas spindlar börjar scanna igenom hemsidan. Därför ska du alltid placera din robots.txt-fil i hemsidans root directory, eftersom det är den första platsen som sökmotorspindlarna börjar leta i för att hitta instruktioner som de behöver.

Du kan använda en robots txt-checker om du vill kontrollera ifall du har en robots txt på hemsidan. Det gör du genom att skriva i “www.namnetpåhemsidan.com/robots.txt” i din webbläsare.

Google rekommenderar att alla som har en hemsida också har en robots-txt-fil installerad. Om en sökmotorspindel inte hittar en sådan fil finns det en risk att endast delar av hemsidan blir genomsökta. Eftersom du via innehållet på alla olika sidor på hemsidan kan nå en högre position på sökmotorernas sökresultat är det viktigt att alla sidor blir genomsökta och indexerade.

Beroende på strukturen på din hemsida så vill du ibland även exkludera delar av din hemsida från sökmotorerna. Ett typexempel av detta är sidor som finns bakom inlogg (till exempel en kontrollpanel) som inte hör hemma att finnas i sökresultaten.

Vad gör robots.txt-filen?

Om du exempelvis har WordPress robots.txt kommer filen kunna blockera vissa delar av hemsidan och indexera andra. Med WordPress robots.txt kan du välja att antingen tillåta eller neka specifika mappar och filer på hemsidan.

Om du godkänner vissa sidor i din WordPress robots.txt kommer sökmotorspindlarna gå till de delarna av din hemsida och indexera dem. Om du istället nekar vissa sidor i din WordPress robots.txt kommer just de sidorna inte att indexeras.

Att göra ett test av robots.txt för att se om du har en sådan fil installerad är just för att du ska tillgängliggöra hemsidan för sökmotorer. Filen är viktig för att du ska kunna bestämma vilka delar av hemsidan som sökmotorerna ska indexera. Om du har delar av hemsidan som inte känns viktig för dig kan du helt enkelt blockera dem i filen så att de inte kommer indexeras. Om du inte alls vill att din hemsida ska indexeras av sökmotorerna kan du till och med använda robots txt för att blockera hela hemsidan.

Hur filen fungerar

Sökmotorer använder olika typer av spindlar när de letar igenom hemsidor. När du tillåter eller nekar delar av din hemsida genom WordPress robots.txt kan du också ställa in vilken sökmotorspindel som instruktionerna ska gälla för. Du kan också addera en * för att informationen i filen ska gälla för alla sökmotorers spindlar. En annan orsak till att använda en robots.txt-checker för att se om du har filen installerad är att med filen kan du blockera allt från URL till kataloger.

Tidsfördröjning

Du kan addera tidsfördröjningar till din robots.txt. Genom en sådan kan du kontrollera när en sökmotorspindel ska leta igenom din hemsida. Du kanske inte vill att hemsidan ska letas igenom för snabbt, och då kan tidsfördröjning komma till nytta. Att använda den här funktionen är bra om du inte vill att din server ska bli överbelastad.

Något som däremot är viktigt att veta är att Google inte stöder tidsfördröjningar. Om du inte vill att Googles botar ska överbelasta servern kan du istället justera hastigheten som botarna instrueras använda. Om du ställer in en längre önskad hastighet kan det hända att Googles spindlar kommer leta igenom hemsidan något långsammare.

Mönstermatchning

Oavsett om det gäller Google eller någon annan sökmotor kan du instruera dem att gå igenom och indexera hemsidan utifrån regler som du har ställt upp. Mönstermatchning är förenat med ett antal regler som du vill att sökmotorspindlarna ska följa. Exempelvis kan du blockera en URL som använder ordet “hemsida”.

Därför ska du använda robots.txt

Är du orolig för att en eller flera tredjeparter scannar din hemsida kan du göra ett robots.txt test för att kontrollera om du har filen installerad. Om du inte har det kan du nämligen installera filen för att neka tredjeparter att scanna hemsidan. Förutom att sökmotorer går igenom sidan finns det även andra som gör det. Alla parter som scannar igenom hemsidan kommer göra att den fungerar långsammare och servern kan inte arbeta på full kapacitet. Det kan resultera i att de som besöker din hemsida upplever den som seg och långsam. En tredjeparts-widget kan också skapa problem med servern som du senare kommer behöva lösa.

Ifall du vill vara säker på att inga tredje parter kopierar innehåll från din hemsida eller analyserar ändringar som du gör på sidan ska du använda en robots txt-checker och göra ett robots.txt test för att säkerställa att filen finns. Du kan nämligen använda den för att blockera och filtrera bort sådant som du inte vill ha på hemsidan. Visserligen kan en eller flera tredje parter använda sig av programvara som gör att de kan komma förbi alla delar du har blockerat. Därför kan du inte enbart förlita dig på just användningen av en robots.txt-fil för att skydda alla delar av din hemsida.

Robots txt-checker

Du kan använda Google Search Console för att se om du blockerar en sida med robots txt-checker. Det är alltid bra att göra ett robots.txt test för att säkerställa att du inte har blockerat någon viktig del av hemsidan i misstag. Eftersom det kan vara dåligt för din hemsida och dig själv om fel delar är blockerade från att indexeras, är det bra att med jämna mellanrum göra ett robots.txt test. Att använda just Google Search Console för att göra ett robots.txt test är väldigt enkelt.